Meta 最新版本的 Quest SDK 添加了拇指微手势功能,允许用户滑动和点击食指,并提高了 Audio To Expression 的质量。

此次更新还包括用于直通摄像头访问的辅助实用程序,这是 Meta 刚刚向开发者发布的功能。如果用户授予权限,应用程序可以访问耳机的前置彩色摄像头,包括镜头内在函数和耳机姿态等元数据,开发者可以利用这些信息运行自定义计算机视觉模型。

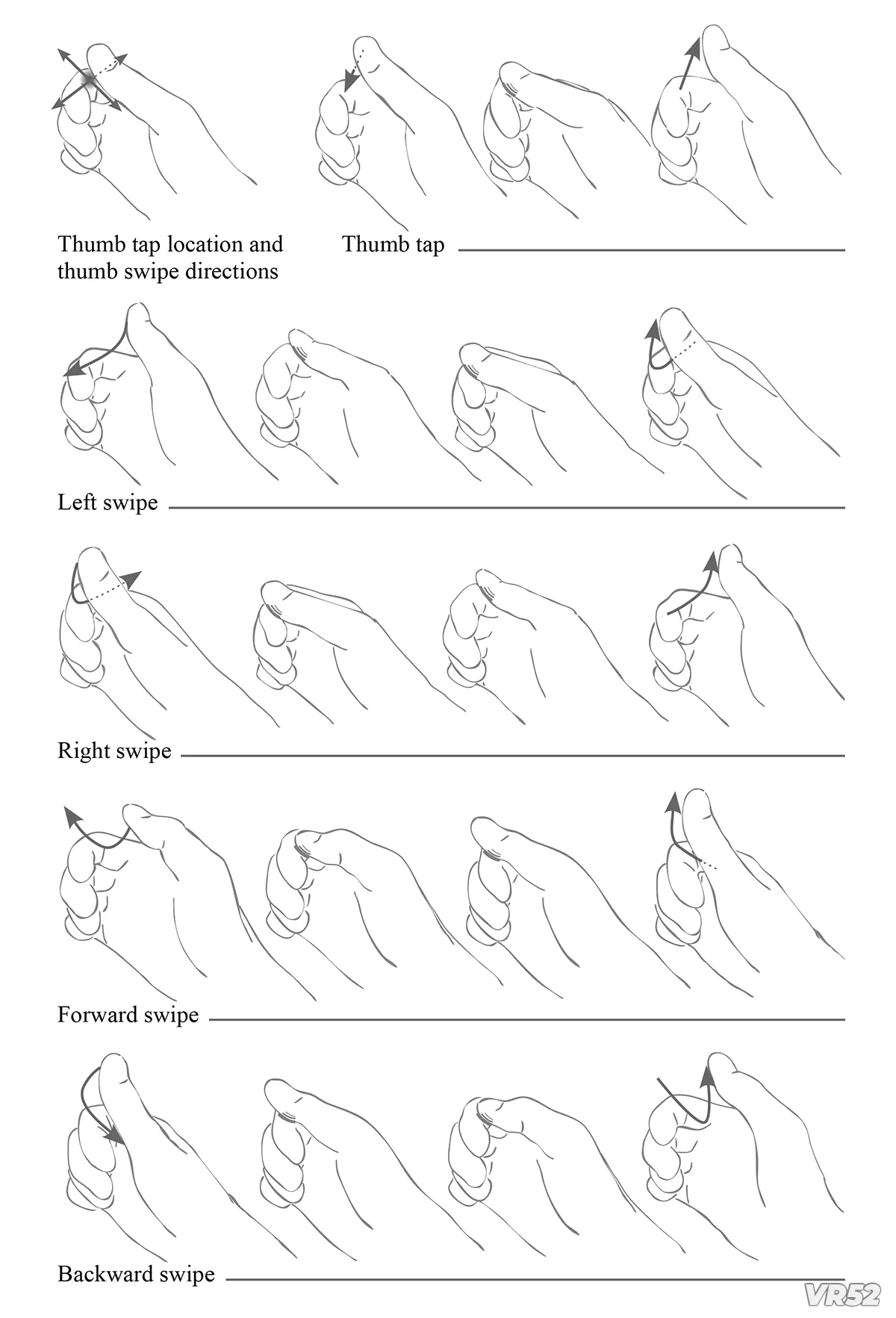

微手势利用了 Quest 耳机免控制器手部追踪功能,在您的手侧向且手指弯曲时,检测您在食指上进行的拇指点击和滑动动作,就像它是 Steam 控制器的 D-pad 一样。

在 Unity 中,微手势需要使用 Meta XR Core SDK。

对于其他引擎,可以通过 OpenXR 扩展 XR_META_hand_tracking_microgestures 来实现。

Meta 表示,这些微手势可以用于实现无需控制器的快速转动远距传送,但实际如何使用微手势则取决于开发人员。例如,开发人员可以用它们作为一种不那么费力的方式来浏览界面,而无需伸手或指向元素。

有趣的是,Meta 还将这种拇指微手势方法应用于其正在开发的 sEMG 神经腕带,这是其未来 AR 眼镜的输入设备。据报道,该技术也可能用于其计划于今年晚些时候推出的 HUD 眼镜。这表明 Quest 头戴式设备可以用作这些未来眼镜的开发平台,利用拇指微手势,但要完全匹配 Orion 原型的全部输入功能,还需要眼动追踪的支持。

Audio To Expression 是在 SDK v71 中引入的设备端 AI 模型,通过麦克风音频输入生成合理的面部肌肉运动,提供估计的面部表情,而无需任何面部跟踪硬件。

Audio To Expression 取代了已有十年历史的 Oculus Lipsync SDK。该 SDK 仅支持嘴唇,不支持其他面部肌肉,而 Meta 声称 Audio To Expression 实际上比 Oculus Lipsync 占用更少的 CPU。

现在,该公司表示,Meta XR Core SDK v74 带来了升级模型,“与早期模型相比,它改善了情感表达力、嘴部运动和非语音发声的准确性等所有方面”。

然而,Meta 自己的 Avatars SDK 仍然不使用 Audio To Expression,也没有使用由内而外的身体追踪。

VR52网成立于2015年,平台提供VR头显、AR眼镜、配件外设、厂商、测评、行业资讯、游戏与应用、展会活动等。