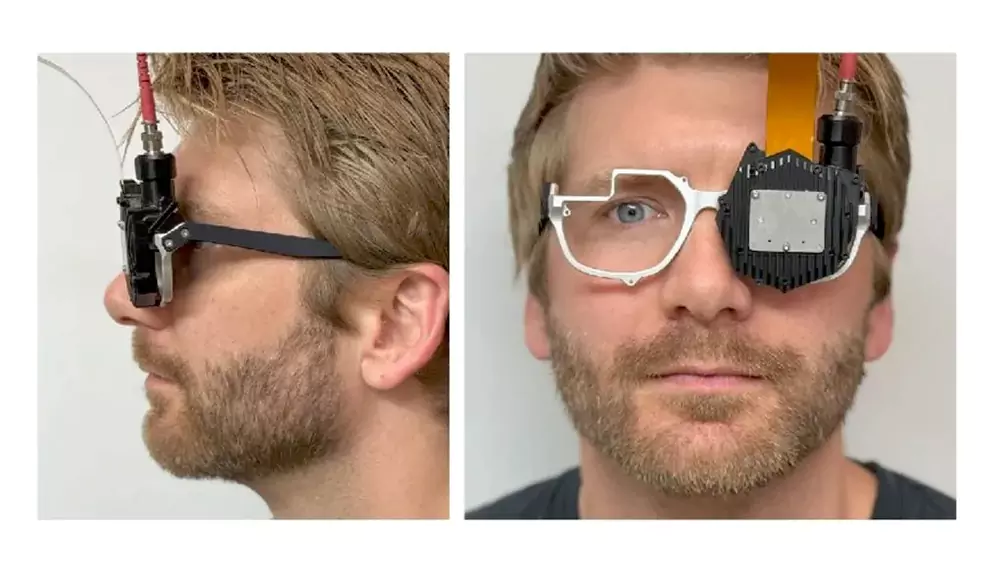

近日,Meta Reality Labs 与 斯坦福大学 研究团队在《Nature Photonics》期刊发表重磅论文,公布一款全新原型级全息混合现实(MR)眼镜。这款设备光学模组厚度仅3毫米,外形接近普通眼镜,却能通过定制波导+空间光调制器(SLM)+AI算法协同工作,生成高度逼真的三维光场图像,被认为是通向“视觉图灵测试”的关键一步。

这不仅是AR/VR硬件的一次飞跃,更可能重新定义未来十年人机交互的形态。

尽管采用了与HoloLens 2、Magic Leap One类似的波导结构,但这款设备并未追求传统意义上的“透明显示”,因此研究人员更倾向于将其定义为混合现实(Mixed Reality),而非增强现实(Augmented Reality)。

其核心区别在于:

❌ 不是简单叠加虚拟图像到现实世界

✅ 而是重建完整的光场,让用户“感知”虚拟物体如同真实存在

“我们的目标不是让数字内容‘浮在眼前’,而是让它‘存在于空间中’。”

——研究团队

这意味着:当你看向一个虚拟杯子时,它不仅有立体感,还能随着你眼球移动产生正确的景深变化、遮挡关系和聚焦效果——就像你在看一个真实的物体。

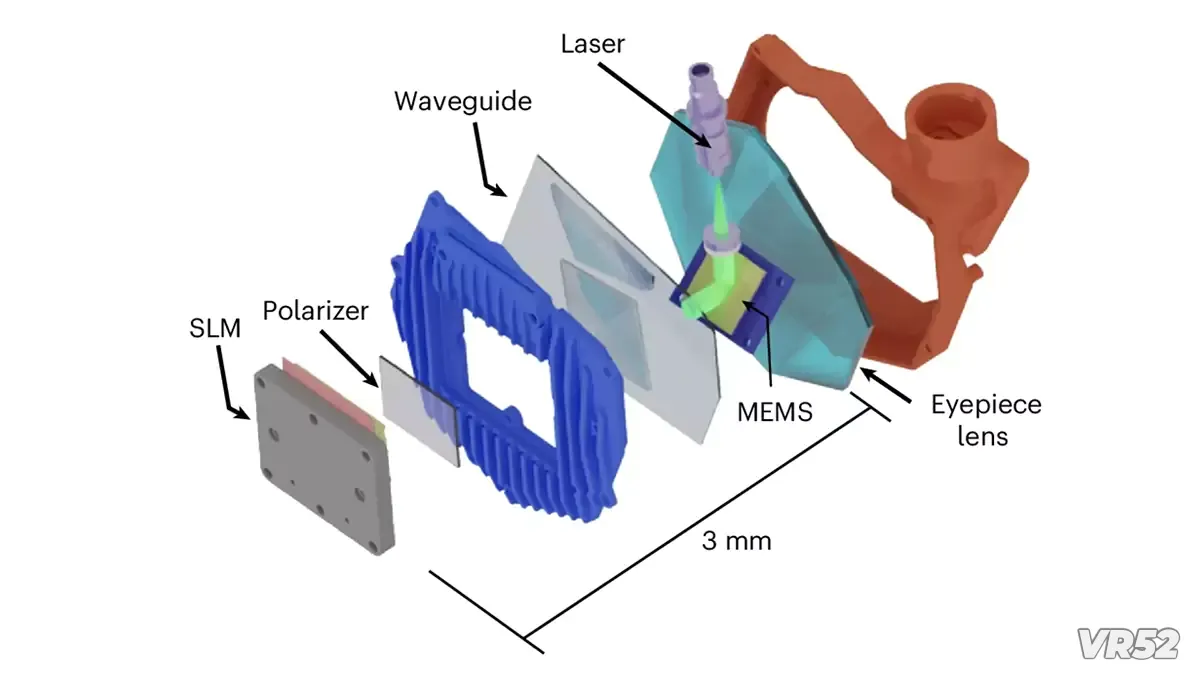

该系统的技术突破集中在三大组件的协同创新:

光学堆栈厚度仅 3毫米

SLM可对光线进行逐像素调制,实现“全分辨率全息光场渲染”

波导负责将生成的全息图像高效引导至瞳孔

| 对比维度 | 传统XR头显(如Quest、Vision Pro) | 新型全息显示 | ||-|-| | 显示原理 | 双目立体图像(两幅2D图模拟深度) | 重建完整光场(真实3D波前) | | 视觉体验 | 存在辐辏-调节冲突(VAC) | 自然聚焦,无视觉疲劳 | | 深度感知 | 有限,依赖大脑“脑补” | 物理级真实,支持自由眼动 |

由于当前SLM的空间带宽积(étendue)有限,难以同时实现大视场角(FOV)和大眼盒(Eyebox),团队引入AI模型进行实时图像校准与增强,显著提升画质与三维感。

“AI帮助我们突破了物理光学的极限。”

——论文作者团队

研究强调,真正沉浸的3D体验必须同时满足两个条件:

| 指标 | 重要性 | ||--| | 视场角(FOV) | 决定沉浸感与视觉覆盖范围 | | 眼盒(Eyebox) | 允许眼睛在一定范围内自由移动而不丢失图像或失焦 |

传统波导受限于“étendue守恒定律”,难以兼顾二者。而该原型通过新型波导设计 + AI补偿,实现了目前同类全息系统中最优的平衡,使用户可自然眨眼、转动眼球,图像依然清晰稳定。

“这是系统真实感和沉浸感的核心之一。”

——Gordon Wetzstein,斯坦福电气工程教授

这项研究是Wetzstein实验室“全息三部曲”的第二章:

第一阶段(2024年):提出并验证高效率全息波导架构,解决小型化中的光效问题。

第二阶段(2025年):构建完整可运行原型,集成SLM与AI算法,实现高质量全息显示。

第三阶段(未来):推出商业化产品,面向消费级市场。

“虽然距离量产还有数年,但我们正走在正确的道路上。”

——Wetzstein

研究人员将这一愿景称为“视觉图灵测试”(Visual Turing Test),灵感源自艾伦·图灵的智能判定标准。

“理想状态下,你无法分辨眼前看到的是真实物体,还是头显投射的数字图像。”

——Suyeon Choi,论文第一作者

这意味着:虚拟内容将不再是“屏幕上的影像”,而是成为你所处空间的一部分——可触摸、可聚焦、可互动。

此次合作也呼应了Meta Reality Labs近期公布的其他光学突破,例如:

超高视场角VR/MR头显:采用“高曲率反射偏振器”等新型非波导光学方案

轻量化设计:保持紧凑护目镜式外形

这些探索表明,Meta正从多个技术路径并行推进,力求在显示质量、体积、舒适度之间找到最优解。

VR52网成立于2015年,平台提供VR头显、AR眼镜、配件外设、厂商、测评、行业资讯、游戏与应用、展会活动等。