继去年首次推出 Android XR SDK(软件开发工具包) 后,谷歌于近日发布了其第二个开发者预览版本(Developer Preview 2)。这一更新带来了多项新功能和改进,包括更广泛的沉浸式视频支持、更强的自适应用户界面布局、ARCore 对手部追踪的支持等。

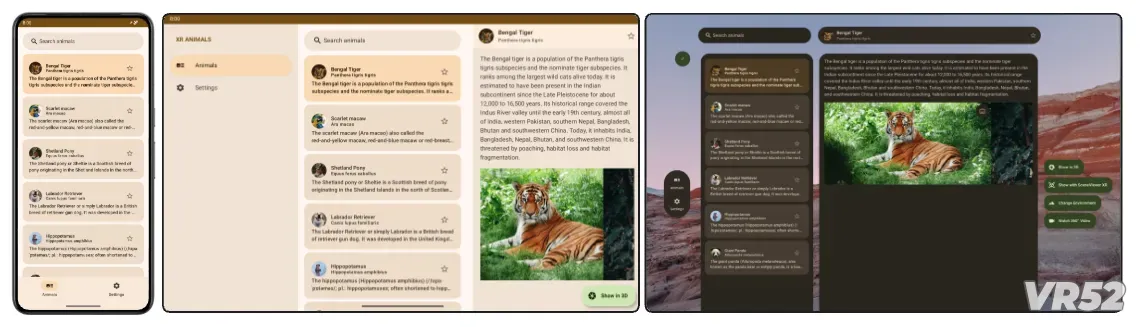

该版本在 Google I/O 2025 大会上正式宣布,标志着谷歌进一步推动其在扩展现实(XR)领域的战略布局。此次更新旨在为开发者提供一套更加标准化、统一的工具链,帮助他们既可以开发原生的 XR 应用程序,也能将现有的 Android 应用轻松适配到头显设备上。

新版 Android XR SDK 引入了对 MV-HEVC 格式 的支持,允许播放高质量的 180° 和 360° 立体沉浸式视频。MV-HEVC 是目前最流行的 3D 视频编码格式之一,专为高画质沉浸式内容优化,适用于 VR 影视、虚拟旅游、教育等多个场景。

谷歌还宣布将 Jetpack Compose 扩展至 XR 平台,使开发者能够通过 SubspaceModifier 和 SpatialExternalSurface 等工具,在各种 XR 显示设备上实现自适应的用户界面布局。

Jetpack Compose 是谷歌推出的声明式 UI 工具集,致力于在手机、平板和沉浸式设备之间统一 UI 设计语言。如今,它也正式成为构建跨平台 XR 应用的重要组成部分。

本次更新中,ARCore for Jetpack XR 的一大亮点是引入了对 手部追踪的支持,涵盖 26 个关键关节点(joint pose),可实现基于手势的交互操作。谷歌为此提供了更新的示例代码、性能基准测试工具以及详细的集成指南,帮助开发者快速将手部追踪功能整合进应用中。

谷歌还在其 Material Design 设计体系 中加入了更多面向 XR 的优化,表示这将有助于“让大屏应用无缝适应 XR 新世界”。这意味着未来的 Material 风格 UI 将更好地适配 VR/AR 设备,带来一致且美观的视觉体验。

尽管 Android XR 正在快速发展,但目前大多数开发者尚未能接触到官方认证的 Android XR 头显设备。谷歌计划在今年晚些时候推出搭载 Android XR 的设备,包括三星的混合现实头显 Project Moohan 和 XREAL 的增强现实眼镜 Project Aura。

因此,Android XR 模拟器 成为了开发者不可或缺的工具。谷歌也在本次更新中大幅优化了模拟器功能,新增了对 AMD GPU 的支持、提升了稳定性,并与 Android Studio 实现更紧密的集成,从而改善整体的 XR 应用测试与开发流程。

作为当前最受欢迎的 XR 开发引擎,Unity 也推出了其 OpenXR 插件第 2 版本的预发布版,带来了多项性能优化:

动态刷新率控制(Dynamic Refresh Rate)

Shader Graph 支持 SpaceWarp 技术(用于提升帧率表现)

此外,Unity 的 Mixed Reality 模板 也进行了重大升级,新增了真实感手部网格遮挡(hand mesh occlusion)和持久锚点(persistent anchors)等功能。

谷歌还发布了针对 Unity 的 Android XR 示例库(Samples),展示了如何在实际项目中集成手部追踪、平面追踪、面部追踪及透视显示(passthrough)等核心功能,为开发者提供了一个良好的起点。

虽然 Android XR 在今年的 Google I/O 上并未成为焦点,但谷歌仍在持续推进其生态建设,不仅将其扩展至更多合作伙伴设备,还计划在未来推出由 Warby Parker 和 Gentle Monster 联合设计的 Android XR 智能眼镜。

据透露,谷歌将推出两种主要型号:

一款外观与功能与 Ray-Ban Meta 智能眼镜 相似的产品;

另一款则配备了内置显示屏,支持执行基本任务,如阅读短信、查看照片与视频、导航等。

你可以在 Android XR Developer Preview 官方页面 获取有关当前所有工具与更新的详细信息,包括完整的 API 文档、示例项目、最佳实践指南等。

VR52网成立于2015年,平台提供VR头显、AR眼镜、配件外设、厂商、测评、行业资讯、游戏与应用、展会活动等。