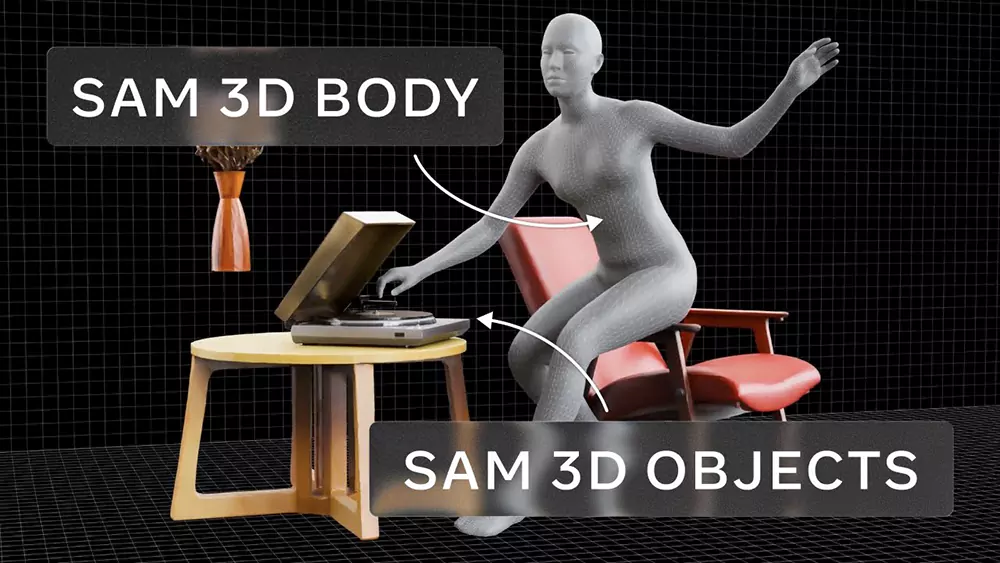

在空间计算浪潮席卷全球之际,Meta 正式推出 Segment Anything Model 3D(SAM 3D),将传统的2D图像理解能力推向全新维度。这项突破性技术仅需单张普通照片,即可精准重建出完整的3D物体、场景甚至人体模型,让每一帧手机快照或网络图片瞬间转化为可交互、可部署的沉浸式数字资产。

过去数十年,我们的数字生活被禁锢在二维屏幕上——点击、滑动、观看,却始终与物理世界隔绝。SAM 3D 正在瓦解这一边界:

一张椅子的照片不再只是静态图像,而是一个可360°旋转、自由缩放、导入虚拟房间的真实3D对象;一个人物快照也能变成可用于社交Avatar或全息通信的立体化身。

Meta 已率先将该技术落地于 Facebook Marketplace 的“View in Room” 功能。用户不再需要凭空想象沙发尺寸是否合适,而是直接将其3D模型“放置”在自家客厅中,从任意角度查看搭配效果——电商体验由此迈入空间化时代。

传统3D重建常因遮挡、杂乱背景或多视角缺失而失败。SAM 3D 却能从容应对这些现实挑战:

即使物体部分被遮挡,系统仍可推断完整结构;

在凌乱环境中精准分离目标主体;

支持非正面、低光照等“不完美”输入。

其背后依托超大规模预训练模型与人在回路(human-in-the-loop)反馈机制,在保证高精度的同时实现接近实时的推理速度,为消费级应用和创意工作流提供坚实支撑。

SAM 3D 的意义远超图像处理本身,它正在催生多个领域的范式变革:

AR/VR内容创作民主化:无需建模技能,拍照即得3D资产;

虚拟零售革命:商品数字化成本骤降,沉浸式购物成为标配;

空间通信新形态:未来视频通话或将传送3D化身而非2D画面;

机器人环境理解:帮助机械臂更准确识别与操作现实物体。

Meta 延续其开放策略,同步开源了 SAM 3D 的模型权重、评估基准与开发者工具包,并上线了直观易用的在线 Playground。全球开发者、设计师、教育者均可立即上手实验,共同推动从“2D屏幕时代”向“动态3D世界”的主流迁移。

一键生成3D:手机照片秒变精细3D模型

零门槛创作:普通人也能制作XR内容

重塑电商体验:家具、服饰“试穿试摆”更真实

赋能硬件生态:为XR眼镜、MR设备提供实时3D引擎

激发全球创新:通过开源持续推动技术演进

https://aidemos.meta.com/segment-anything/gallery

VR52网成立于2015年,平台提供VR头显、AR眼镜、配件外设、厂商、测评、行业资讯、游戏与应用、展会活动等。